在上一篇文章中,我們探討了 LLM 可觀測性平台的重要性。今天,我們將延伸這個主題,深入探討一個與其緊密相關且至關重要的領域:Prompt Management。

多數 LLM 可觀測性平台,如 Langfuse、Langsmith 等,都提供了強大的 Prompt 管理解決方案。這並非偶然,因為 Prompt 管理與模型的可觀測性、評估 (Evals) 功能有著密不可分的關係。當然,市面上也有獨立的 Prompt 管理工具,但今天我們將聚焦於整合性平台,探討它們如何將 Prompt 從簡單的字串提升為企業級的數位資產。

首先,在我們開始了解 Prompt Management 之前,團隊可以根據自身的規模和成熟度,從以下幾點簡單的判斷合適的 Prompt 策略:

了解自己團隊中真正的需求,是否真的需要這些工具與複雜度,還是只是單純的為導入而導入,這也是我們不斷會學習到的課題。

當你在凝視深淵,深淵也在凝視著你。

當一個 AI 應用從概念驗證 (POC) 走向正式生產環境時,將 Prompt 直接寫在程式碼中 (很 hardcoding) 的作法會迅速成為瓶頸。有效的 Prompt 管理變得至關重要,其核心價值在於:

接下來就讓我們從各種角度來拆解Prompt Management 的核心概念,我們將會理解在現今的 LLM 應用發展趨勢中, Prompt 已經不再只是程式碼的一部分,而是整個組織需要重點列管的重要資產 。

在現代 AI 應用中,一個 Prompt 早已不是單一的靜態字串,而是一個可組合、可動態生成的「軟體元件」。它的複雜性與強大之處,正來自於其模組化的組合方式。要精通 Prompt 管理,我們必須先理解構成一個 Prompt 的三大核心要素:模板 (Template)、結構 (Structure) 與 版本 (Version)。

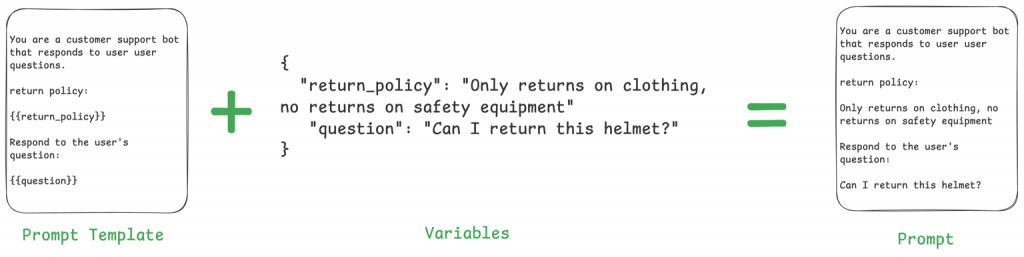

Prompt 模板是將靜態指令與動態資料結合的橋樑。與其將使用者問題寫死在程式碼中,我們使用帶有佔位符的模板,在執行時才將真實資料「注入」其中。這就像是一個填空題,讓我們的 Prompt 能夠應對千變萬化的使用者輸入。

核心價值:

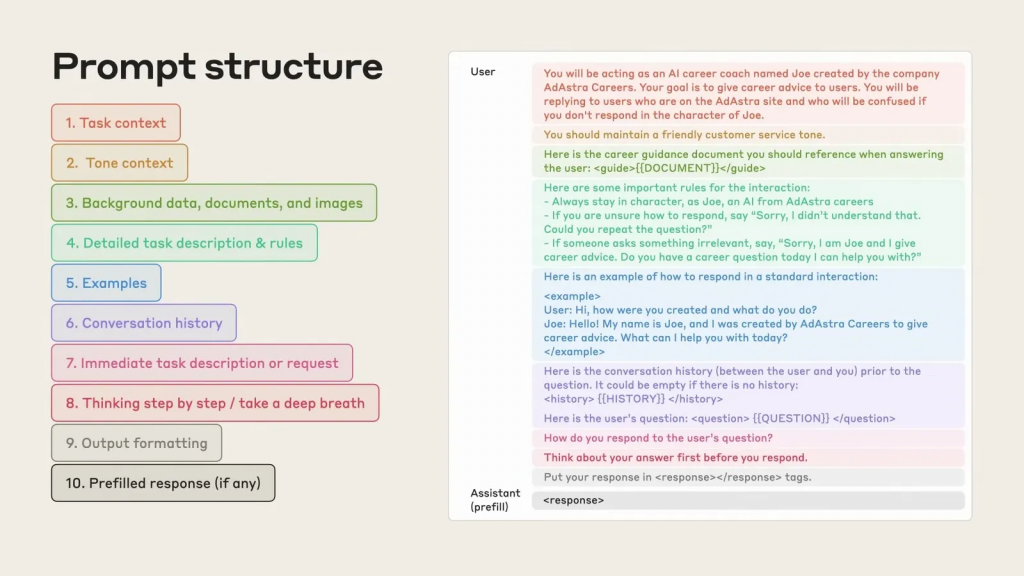

如果說模板是 Prompt 的「血肉」,那麼結構就是其「骨架」。一個高效的 Prompt 不會是雜亂無章的指令堆砌,而是一個經過精心設計、層次分明的引導藍圖。這個結構為模型提供了完成任務所需的所有上下文,確保它能準確、可靠地執行指令。

一個設計精良的 Prompt 結構通常包含以下幾個關鍵部分:

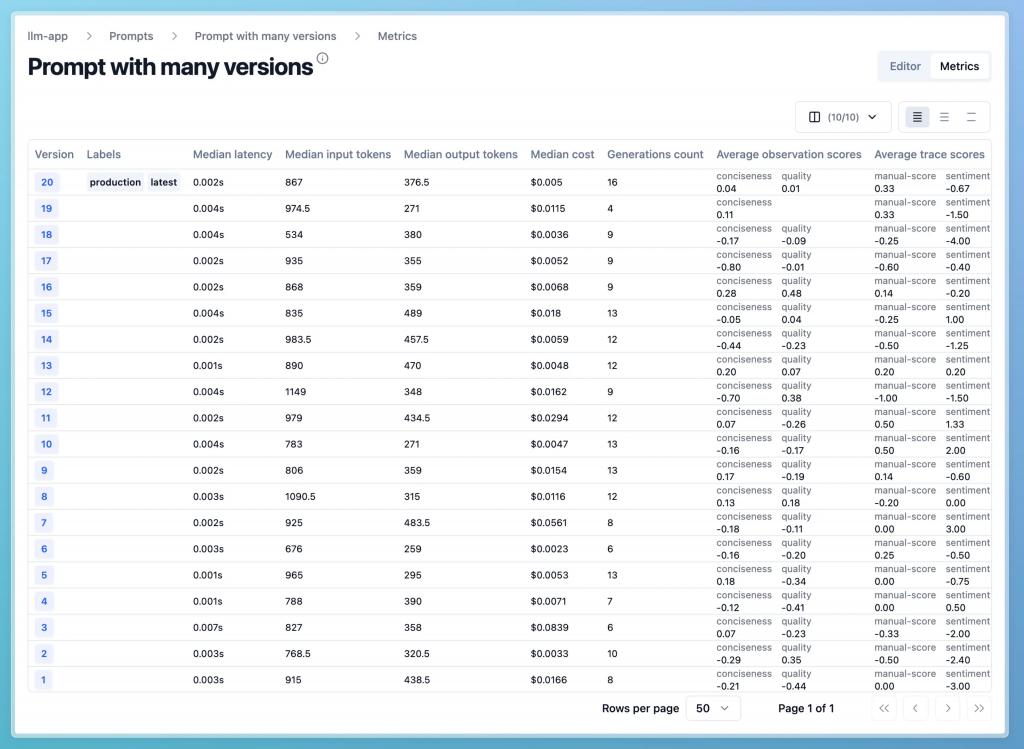

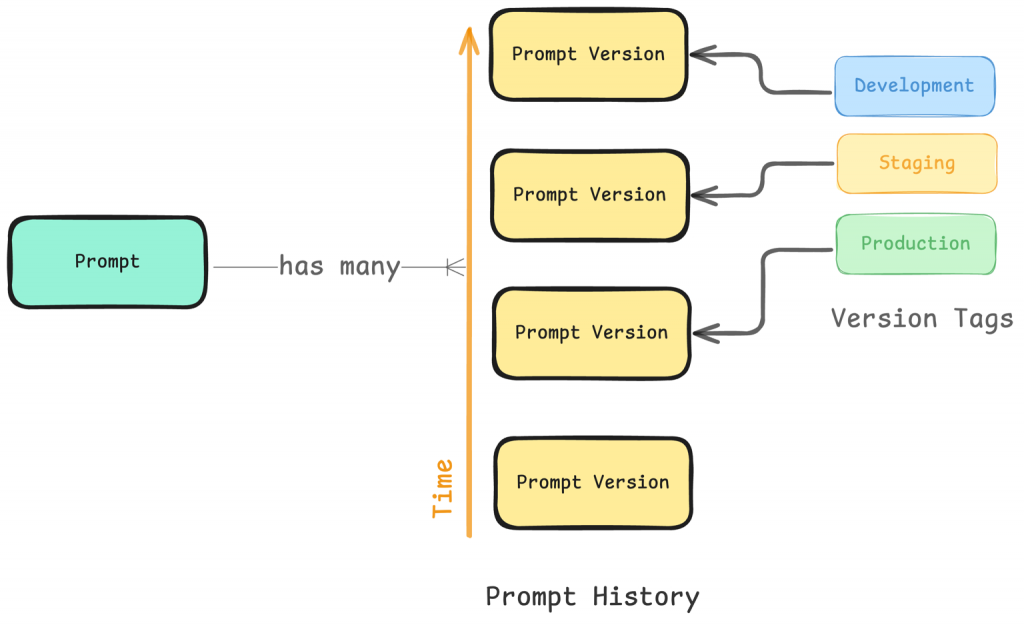

Prompt 不是一次性寫成的完美作品,它是一個需要不斷測試、調整和優化的「活資產」。業務需求會變更、模型會升級、使用者回饋會帶來新的價值,這一切都驅動著 Prompt 的持續演進。這就是版本控制至關重要的原因。

系統化的版本管理帶來了以下好處:

當 Prompt 演變成包含模板、結構和版本控制的複雜資產後,將它們散落在程式碼、Slack 或文件中就成了一場災難。為了解決這個挑戰,一個中心化的 Prompt 管理後台應運而生。它不僅是一個儲存庫,更是一個跨職能團隊的協作中樞與實驗平台。

它的核心價值在於將 Prompt 從應用程式碼中徹底解耦 (Decoupling)。這意味著 Prompt 的修改、測試和部署可以獨立於軟體的發布週期。產品經理、領域專家或 Prompt 工程師現在可以在一個視覺化的介面中,安全地優化 Prompt,而無需撰寫一行程式碼或等待工程師重新部署服務。

這個後台通常提供兩大核心功能,以應對 AI 應用開發中最常見的挑戰:

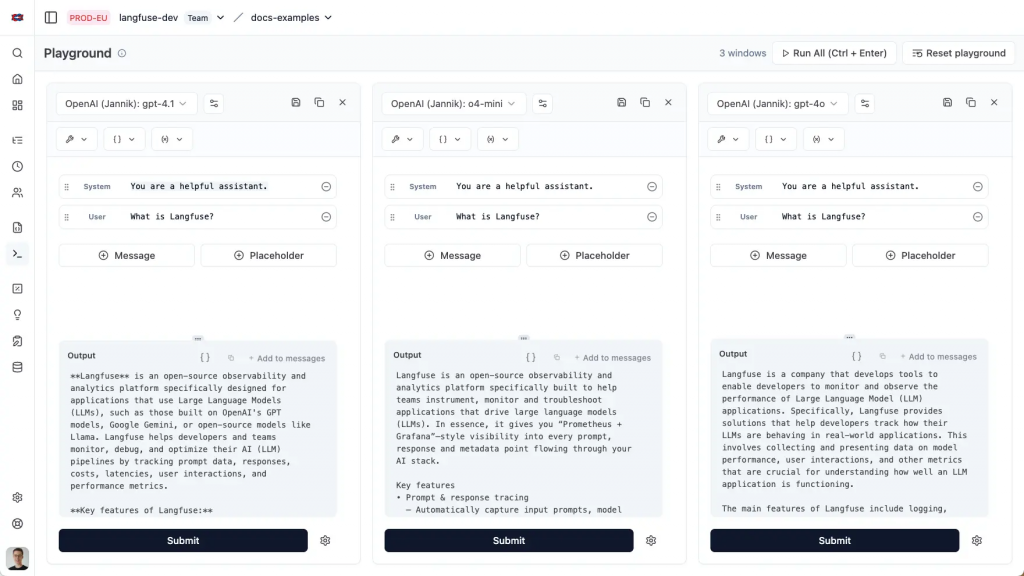

在現實世界中,「最好的 LLM」並不存在,只存在「最適合當前任務的 LLM」。團隊需要基於成本、延遲、準確性及特定領域的知識,在眾多模型中做出權衡。Prompt Playground 正是為此而生的終極實驗場。

它解決了傳統開發流程中的一個巨大痛點:如果沒有 Playground,要比較 GPT-4o 和 Claude 3 Opus 對同一個 Prompt 的反應,工程師可能需要建立兩個獨立的測試分支,這既耗時又繁瑣。

核心價值:

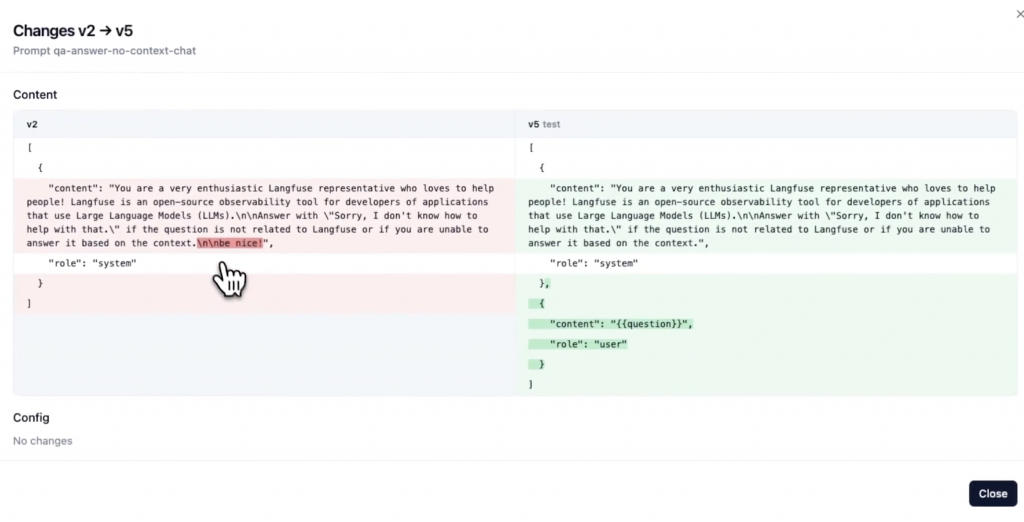

專業的 Prompt 管理平台會自動為每一次變更建立版本紀錄,就像 Git 對程式碼所做的一樣。這條清晰的歷史軌跡是團隊協作與系統穩定性的基石。

核心價值:

僅有版本歷史是不夠的。我們還需要一個機制來管理哪個版本應該在哪個環境中使用。這就是「標籤」發揮作用的地方,它將軟體開發中成熟的環境管理 (Environment Management) 概念引入到 Prompt 管理中。

我們可以建立如 development、staging 和 production 等標籤,並將它們指向特定的 Prompt 版本。

這個流程確保了任何變更都必須經過層層驗證,才能被「晉升」到生產環境,極大地提升了穩定性。

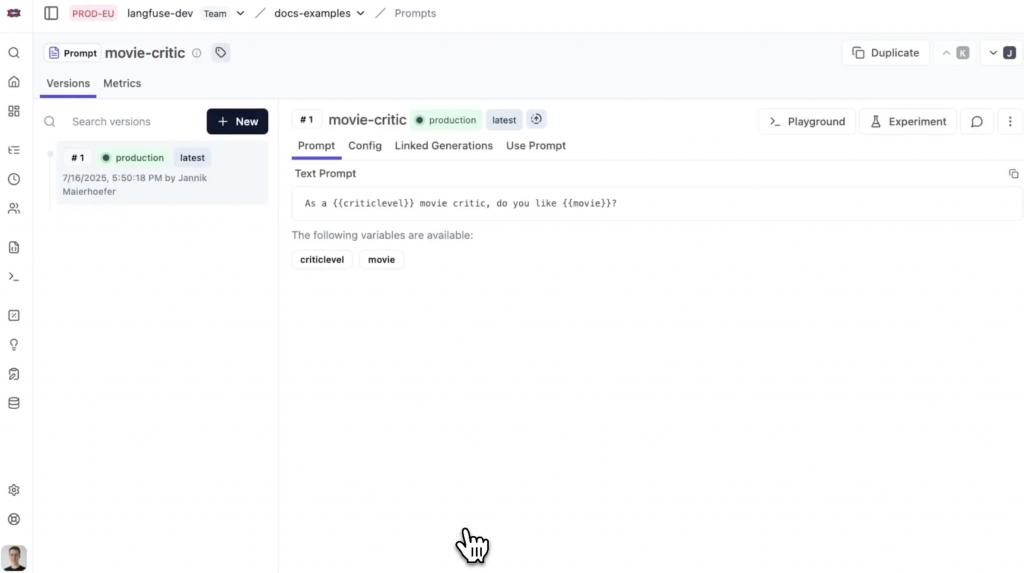

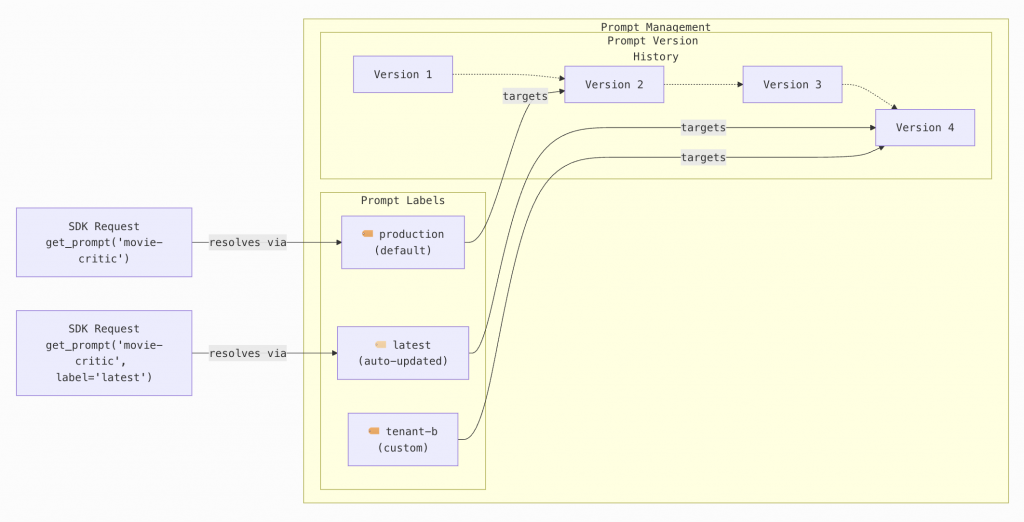

最後,這一切是如何在應用程式中生效的呢?答案是透過平台提供的 SDK。應用程式的程式碼不再包含巨大的 Prompt 字串,而是變成一個簡單的 API 呼叫。

如上圖的程式碼所示,開發者只需告訴 SDK:「請給我名為 movie-critic 的 Prompt,並且是我標記為 production 的那個版本」。

這種模式實現了終極的靈活性:Prompt 團隊可以在後台將 production 標籤從 v2 更新到 v3,線上應用程式無需重新部署,就會在下一次請求時自動拉取並使用最新的 Prompt。這真正實現了 Prompt 的執行時更新 (Runtime Update)。

雖然一個功能強大的 UI 讓 Prompt 的編輯變得前所未有的簡單,但它也帶來了一個新的問題:我們如何將這個「UI 驅動的變更」與企業級軟體開發中「以 Git 為中心」的『單一事實來源 (Single Source of Truth)』原則相協調?

答案就是 GitOps!將 Prompt 管理與 Git 工作流整合,是實現 Prompt 生命週期完全自動化、可追溯性與可靠性的終極形態。它完美地橋接了兩個世界:Prompt 工程師喜愛的視覺化介面與開發維運團隊信賴的自動化 CI/CD 管線。

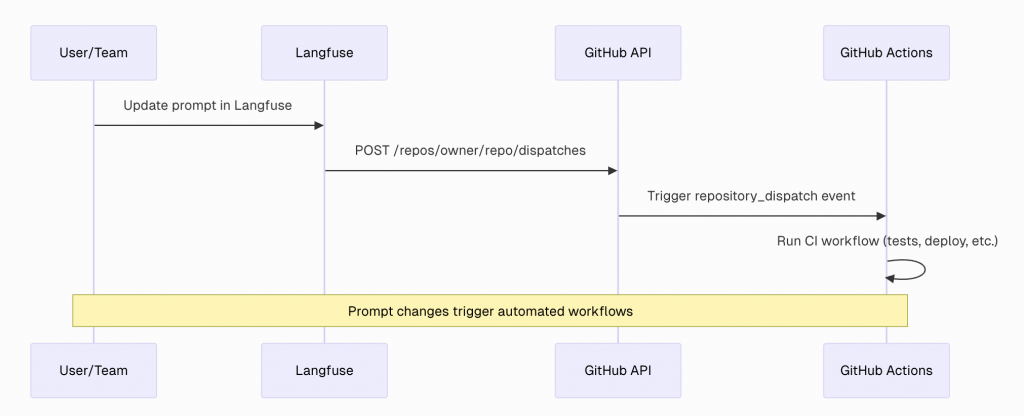

最無縫的整合方式是平台原生提供。以 Langfuse 為例,它內建了與 GitHub Actions 的深度整合,將手動操作轉化為自動化流程。

這個流程的運作方式如下:

並非所有平台都提供如此深度的原生整合。更常見且靈活的作法是提供 Webhook 功能。Webhook 就像是一個通用的通知系統:當 Prompt 被更新時,平台會向你指定的 URL 發送一個包含變更資訊的 HTTP POST 請求。

這種方式給予了團隊極大的自由度:

無論是透過原生整合還是 Webhook,其最終目標都是啟動一個自動化的工作流。這個工作流遠不止是簡單的備份,它是一個保障品質與穩定性的安全閥。一個典型的 Prompt GitOps 工作流會包含以下步驟:

透過這套流程,我們將 Prompt 的生命週期管理從手動操作,提升到了企業級 CI/CD 的高度,其核心價值在於:

當我們將 Prompt 從程式碼中解耦,並透過一個中心化後台在執行時動態載入時,我們無形中創造了一個新的關鍵基礎設施。get_prompt 這個看似簡單的函數呼叫,從一個內部操作,演變為一個必須在生產環境中 24/7 可靠運行的網路服務。

這種架構轉變雖然帶來了巨大的靈活性,但也引入了一個嚴峻的挑戰:單點故障 (Single Point of Failure, SPOF)。如果 Prompt 管理系統變慢或停機,所有依賴它的 AI 應用程式將會立刻降級甚至完全癱瘓。因此,其後端架構必須滿足企業級的嚴苛標準。

這主要體現在三大核心挑戰上:

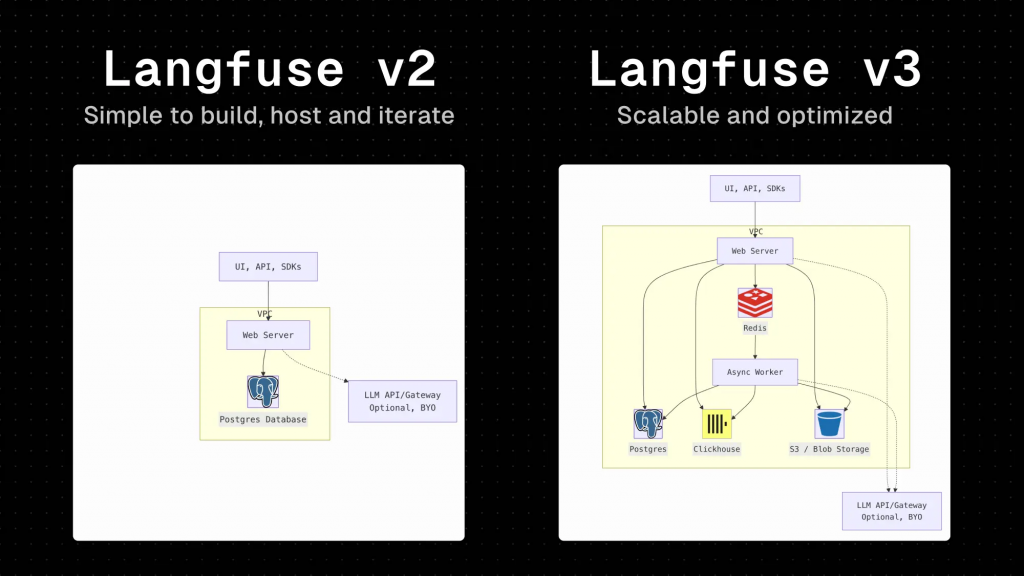

為了具體理解如何應對這些挑戰,讓我們深入分析 Langfuse 這個真實世界的例子。其架構從 v2 到 v3 的演進,完美地展示了一套 Prompt 管理系統如何從一個簡單的應用,成長為一個為大規模生產環境設計的健壯服務。

Langfuse v2 的架構相對簡單:一個 Web Server 直接與一個 Postgres 資料庫溝通。

意識到 v2 架構的局限性,Langfuse v3 進行了徹底的重新設計,其核心思想是關注點分離 (Separation of Concerns),並為每個任務選擇最合適的工具。

get_prompt 請求會直接命中速度極快的 Redis 記憶體快取,而無需訪問較慢的後端資料庫。這確保了即使在巨大流量下,也能維持毫秒級的響應時間。透過這次架構升級,Langfuse 確保了 get_prompt 不再僅僅是一個功能,而是一個能夠支撐企業級 AI 應用的高可用、低延遲、高擴展性的核心服務。這個演進路徑對於任何希望將 AI 應用推向大規模生產的團隊來說,都具有深刻的借鑒意義。

回顧全文,將 Prompt 視為軟體開發生命週期的一部分,並引入類似 DevOps 的管理思維是成功擴展 AI 應用的關鍵。

從最初的混亂到最終的自動化流程,我們可以將一個成功的 Prompt 管理策略總結為以下幾個核心實踐。無論你選擇哪種工具,這些原則都將是通往成功的基石:

| 實踐項目 | 說明 | 關鍵效益 |

|---|---|---|

| 版本控制 (Versioning) | 如同使用 Git 管理程式碼,系統性地追蹤 Prompt 的所有變更、紀錄修改原因,並能在必要時輕鬆回滾到舊版本 。 | 提升可靠性、可追溯性與實驗效率 。 |

| 集中式儲存庫 (Centralized Repository) | 將所有 Prompt 統一存放在一個中央資料庫或設定檔中,而不是分散在程式碼、Slack 或文件中 。 | 建立單一事實來源 (Single Source of Truth),避免混亂 。 |

| 結構化文件 (Structured Documentation) | 為每個 Prompt 版本紀錄其元數據 (Metadata),如用途、目標受眾、使用的模型參數 (如溫度) 和預期產出格式 。 | 確保結果的可複製性,方便未來除錯與優化 。 |

| 協作工作流 (Collaborative Workflows) | 建立類似程式碼審查 (Pull Request) 的流程,讓團隊成員可以對 Prompt 的修改提出建議和審核 。 | 讓非技術人員也能安全地貢獻其專業知識 。 |

| 系統化測試與驗證 (Testing & Validation) | 在部署前,針對新的 Prompt 版本進行自動化測試,比較新舊版本的產出差異,並評估準確性、語氣、成本等關鍵指標 。 | 避免在生產環境中出現意外的品質下降或迴歸問題 。 |

| 持續監控 (Continuous Monitoring) | 在生產環境中持續追蹤 Prompt 的表現,監測用戶滿意度、錯誤率、延遲和 Token 使用成本等指標,並設定警報 。 | 及早發現因模型更新或用戶行為變化導致的 Prompt 失效問題 。 |

| 環境管理 (Environment Management) | 仿照軟體開發,為 Prompt 設立開發 (dev)、預備 (staging) 和生產 (production) 等不同環境,確保變更經過充分驗證才上線 。 | 避免開發中的實驗性變更意外影響到正式用戶 。 |

隨著 AI 技術的飛速發展,Prompt 管理本身也在不斷進化,但這絕對不會是終點。未來,我們將看到更多利用 AI 自動優化 Prompt 的技術、針對 Prompt 注入攻擊的防禦手段,以及將 Prompt 管理與 CI/CD 管線更深度整合的創新實踐。將 Prompt 視為核心資產並加以妥善管理,將是所有成功 AI 應用的共同特徵。

References: